Works Applicationsに所属しており、業務委託としてRevCommで働いている勝田です。8月末に開催されたNLP若手の会 (YANS)に参加し、発表を行いました。今回のブログ記事ではその報告をします。

YANSの概要について

- 名称:NLP若手の会 (YANS) 第18回シンポジウム (2023)

- 開催日:2023年8月29日(火) - 31日(木)

- 29日はハッカソンのみ、シンポジウムは30日と31日の2日間で開催

- 会場:浅草橋ヒューリックホール

- リンク:https://yans.anlp.jp/entry/yans2023

2020年からオンラインでの開催が続いたため今回は4年ぶりの現地開催であり、対面での交流や議論はオンラインの時とは違った盛り上がりでした。参加者は300人、発表数は140件と去年よりも多く、特に発表数は去年の倍近い件数となっており、チケットの獲得時点から今年は雰囲気が違うと感じました。ChatGPTやLLM関連の発表が多く、サービスに近い業務にNLPを応用するハードルが下がってきたのではと思いました。

発表について

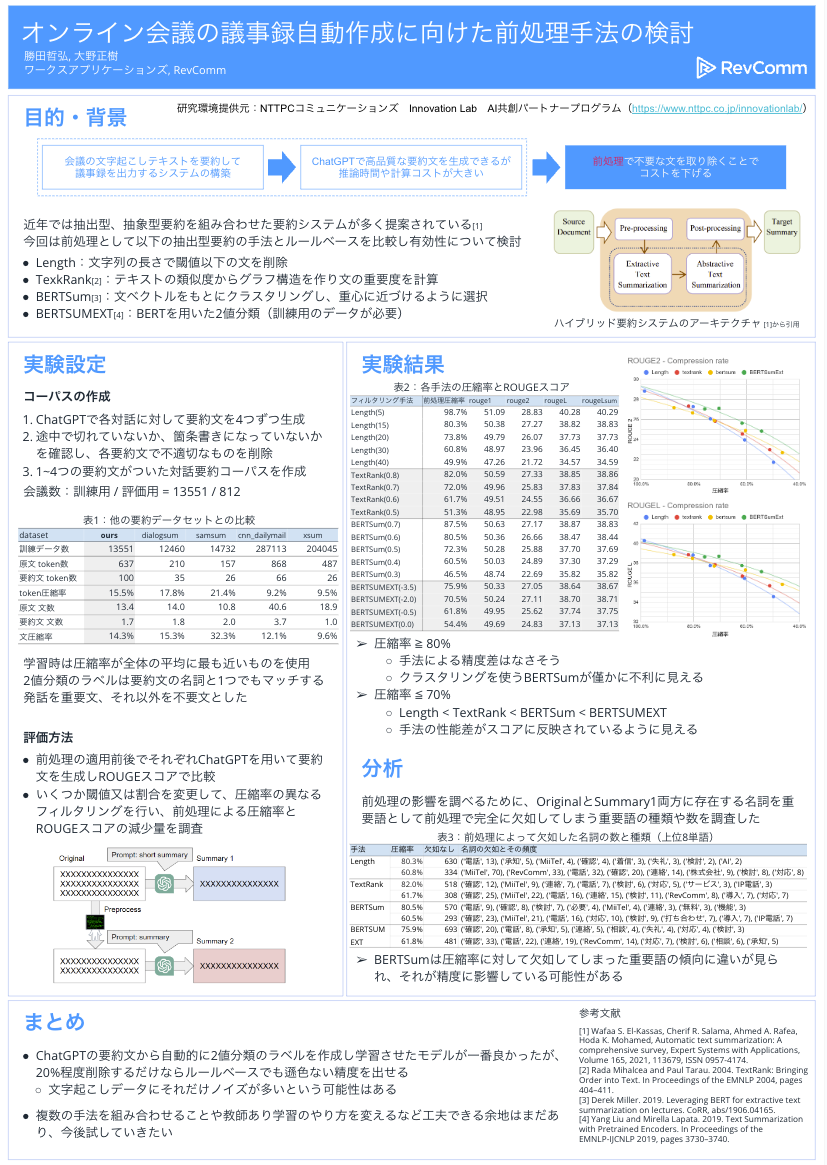

タイトル:[S1-P09] オンライン会議の議事録自動作成に向けた前処理手法の検討

概要: ChatGPTや事前学習済みLLMを使うことで高品質な要約文を容易に生成できますが、テキスト長が大きくなれば、推論に時間がかかり計算コストが大きくなります。ここでは、オンライン会議の会話の文字起こしテキストを要約し、議事録を出力するシステムを作ることを目標にコストと精度の観点から前処理+要約のシステムを評価しました。特に会話の文字起こしテキストには、フィラーや定型的なやり取りなど、議事録に不要な表現が多く出現します。そのため、要約の前処理として不要な文を取り除くことで、計算コストを下げることが期待できます。そこで、実際のオンライン会議の会話の文字起こしテキストに、ルールベースや機械学習ベースの前処理を適用し、前処理の有効性について調査を行いました。

ポスター資料:

頂いた質問

オラクルの評価も行って、ある程度の上限値を見ると参考になるのではないか

- YANSまでに準備は間に合わなかったが、圧縮率に対するROUGEスコアが最大となる組み合わせを抽出した結果を見てみたいとは考えている。

名詞の抽出方法はどうしたか

- 形態素解析にはspaCy(ja_core_news_sm)を使った。

系列ラベリング的な手法は取らないのか

- システムに導入する上でコストや処理時間を考慮してできるだけシンプルな手法にしたいので文単位での2値分類で解くことにした。

アライメントを取るうえでコンテキストを考慮した方が精度が良いのではないか

- 上記と同様な理由で今回は試せていない

ルールベースの前処理をしたうえで機械学習で解いた方がよいのではないか

- ルールベースと機械学習の手法を組み合わせることはできるが、機械学習が現状のデータセットに対してどの程度対処できるかを見たかった。

2値分類の精度はどれくらい出ているか

- 教師ありで学習させた場合は76%程度の精度となった。

まとめ

8月末に開催されたNLP若手の会 (YANS)の参加報告を行いました。私の発表に聴講や議論をしてくださった方に感謝申し上げます。オフラインでの交流ということもあり、ポスターを挟んでの直接の議論は得るものも多かったように感じます。

今後の研究方針としてどう精度を上げるかという問題もありますが、コストを無視することはできずコストパフォーマンスの良い手法を模索する必要があります。

例えば、FrugalGPT[1]では簡単なタスクは小さくコストが安いモデルに解かせ、難しいタスクになるほどコストをかけて大きいモデルに切り替えるといった戦略を取ることで精度を下げずに98%のコスト削減を行っています。

今回はChatGPTを使って要約を行うことを想定しており、そこではChatGPTが一番コストになるためその役割をどれだけ減らせるかという観点で”コスト≒圧縮率”として計算を簡略化しています。しかし、実際は前処理にもコストは発生しますし、それはどの手法を使うかによっても変わってきます。最終的にはシステム全体でのコストを見積りつつ、コストと精度の観点から最適な組み合わせを見つけたいと考えています。

謝辞

本研究にあたり、NTTPCコミュニケーションズが提供するInnovation LabのAI共創パートナープログラムにおいてサーバ環境を無償でご準備いただきました(補足:RevCommはこのプログラムのパートナーとして採択されています)。NTTPCコミュニケーションズに感謝を申し上げます。

引用

[1] Lingjiao Chen, Matei Zaharia, James Zou, “FrugalGPT: How to Use Large Language Models While Reducing Cost and Improving Performance”, paper